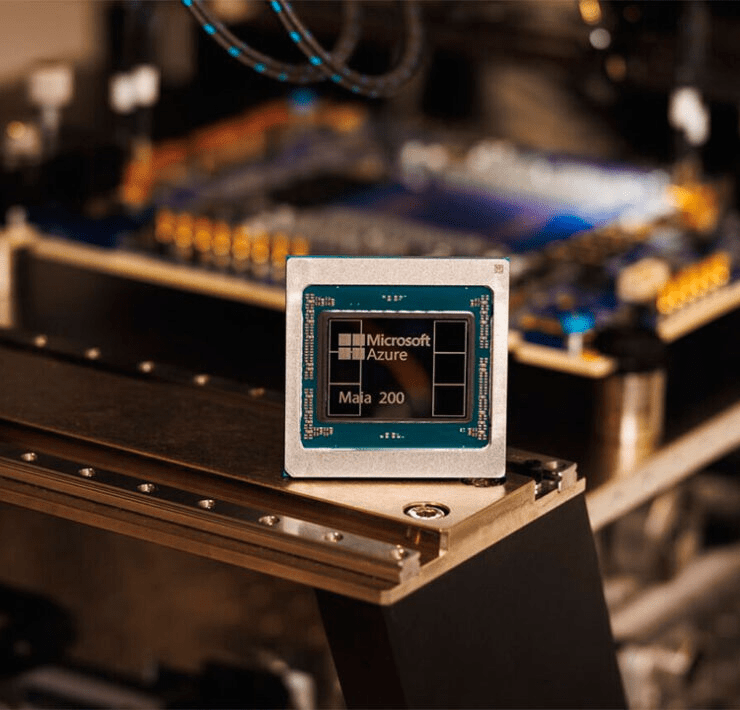

Microsoft lanza el chip de IA Maia 200 y desafía a Amazon y Google

La carrera por el desarrollo de chips de inteligencia artificial (IA) continúa acelerándose, y Microsoft ha dado un paso significativo con el lanzamiento de su nuevo chip Maia 200. Este acelerador de IA, fabricado con el proceso de 3 nm de TSMC, representa un avance sustancial frente a las generaciones anteriores y posiciona a Microsoft como un competidor directo frente a los chips de Amazon y Google. La compañía asegura que Maia 200 está diseñado no solo para soportar los modelos de IA actuales, sino también para enfrentar desafíos futuros de gran escala.

Cada chip Maia 200 incorpora más de 100 000 millones de transistores, optimizados para ejecutar cargas de trabajo de IA complejas de manera eficiente. Microsoft resalta que su desempeño en operaciones FP4 es tres veces superior al Amazon Trainium de tercera generación, mientras que en FP8 supera al TPU de séptima generación de Google. Este incremento de rendimiento convierte al Maia 200 en un sistema de inferencia más eficiente, con un rendimiento un 30 % superior por dólar en comparación con el hardware previo de la compañía.

El chip será fundamental para potenciar modelos de gran escala, incluido GPT-5.2 de OpenAI, así como aplicaciones en Microsoft Foundry y Microsoft 365 Copilot. Scott Guthrie, vicepresidente ejecutivo de Nube e IA de Microsoft, asegura que Maia 200 puede ejecutar los modelos más grandes del momento con margen suficiente para desarrollos futuros aún más exigentes.

“Maia 200 ofrece un rendimiento FP4 tres veces superior al Amazon Trainium y supera al TPU de Google.”

A diferencia del lanzamiento del Maia 100 en 2023, Microsoft ahora establece comparaciones directas con sus competidores. Amazon, trabajando junto con Nvidia, planea integrar su próximo Trainium4 con NVLink 6 y la arquitectura de rack MGX, mientras que Google avanza con su propia séptima generación de TPU. La competencia en chips de IA se intensifica, y cada empresa busca optimizar el rendimiento, eficiencia y escalabilidad de sus soluciones.

Además de su despliegue en centros de datos Azure, Microsoft está ofreciendo acceso anticipado a académicos, desarrolladores y laboratorios de IA, incluyendo colaboraciones en modelos de código abierto, lo que podría fomentar un ecosistema más amplio de innovación y pruebas prácticas con el Maia 200.

Con el Maia 200, Microsoft refuerza su estrategia de liderazgo en IA en la nube y acelera la adopción de modelos de gran escala. Su eficiencia, rendimiento superior y enfoque en colaboración con la comunidad académica y de desarrollo sitúan a este chip como un actor clave en la próxima generación de tecnología de inteligencia artificial. A medida que Amazon y Google avanzan con sus propias soluciones, la competencia promete acelerar la innovación y ofrecer nuevas capacidades para empresas y desarrolladores que dependen de IA de alto rendimiento.